Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №139 /llama/

Аноним

13/06/25 Птн 02:36:30

№

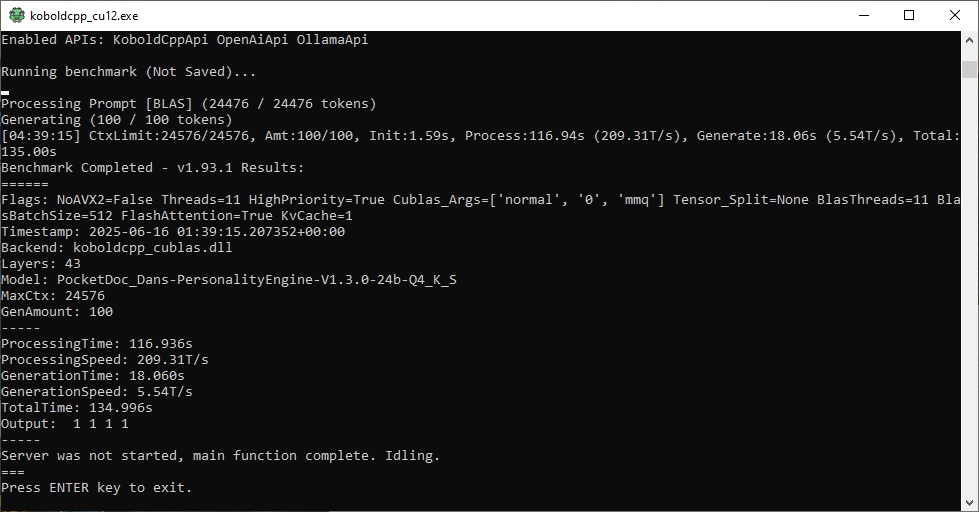

1