Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №154 /llama/

Аноним

08/08/25 Птн 23:32:12

№

1

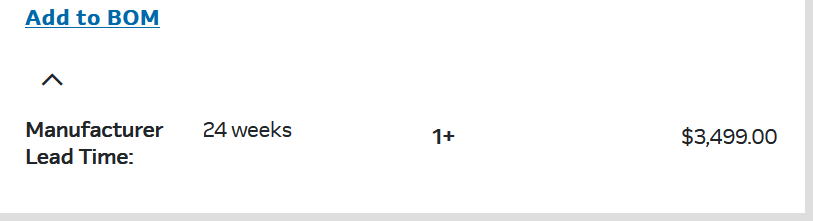

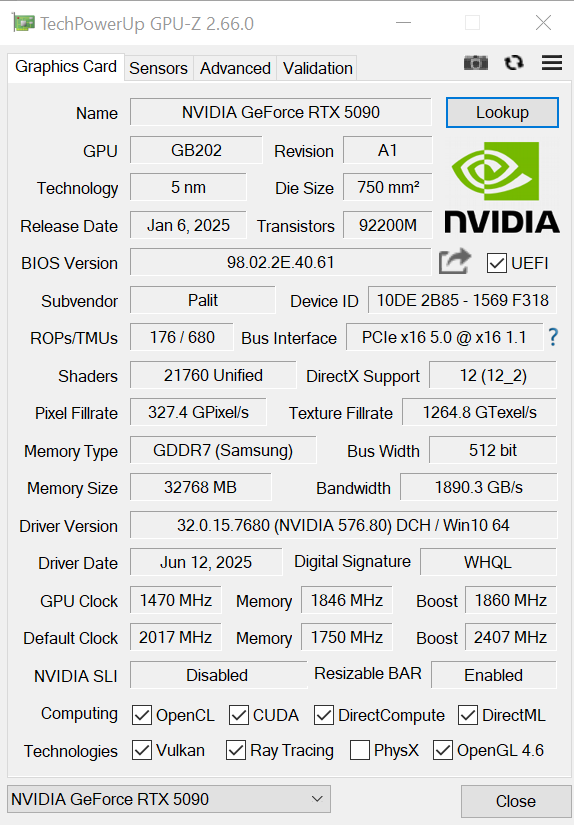

Видеокарта Zeus не только должна превзойти RTX 5090 в 10 раз, но и получить расширяемую видеопамять

Аноним

10/08/25 Вск 15:07:01

№

271