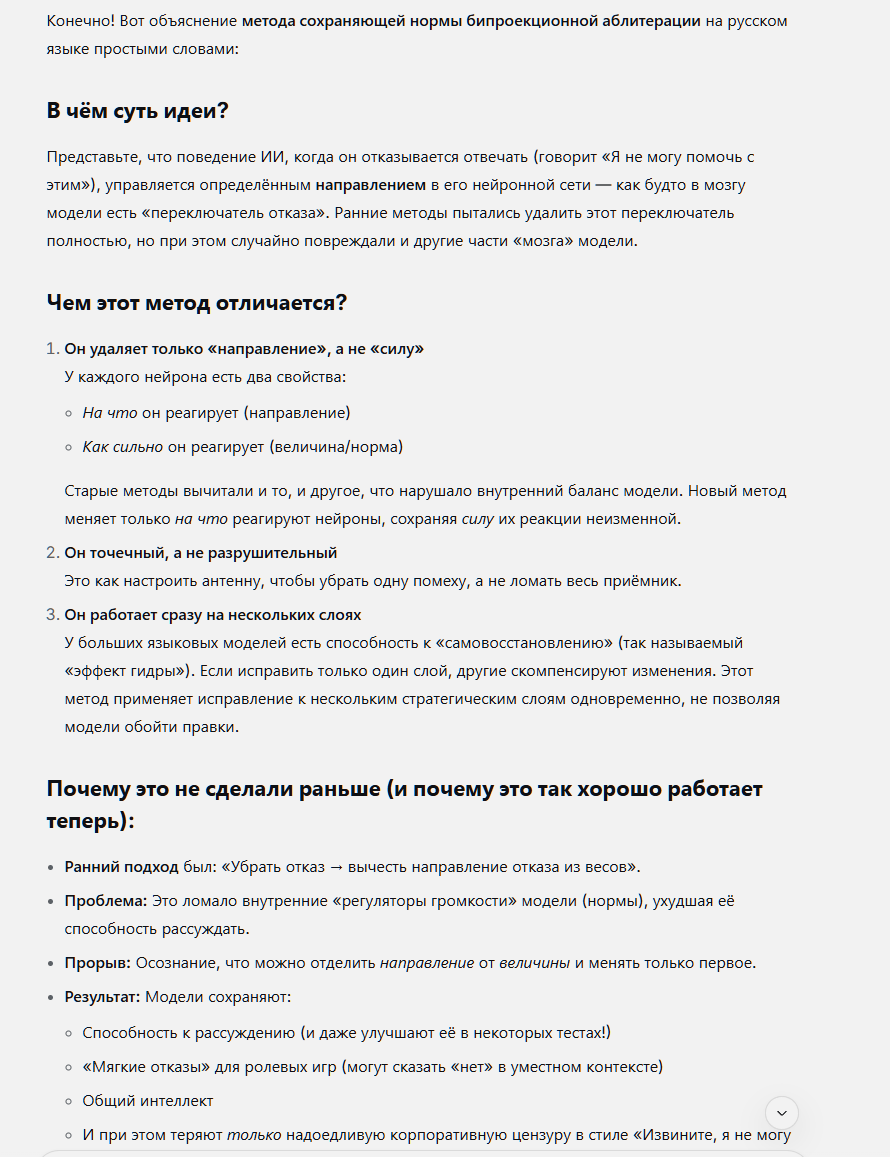

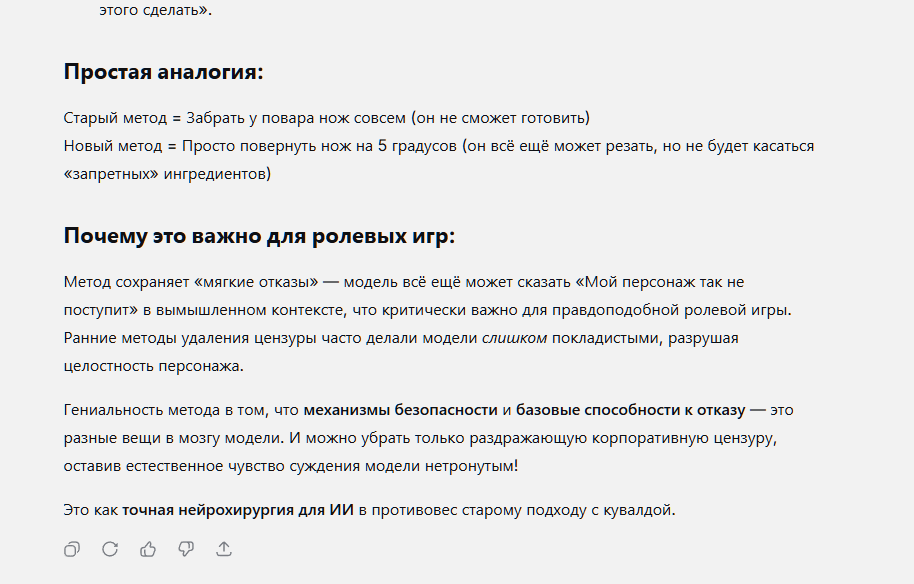

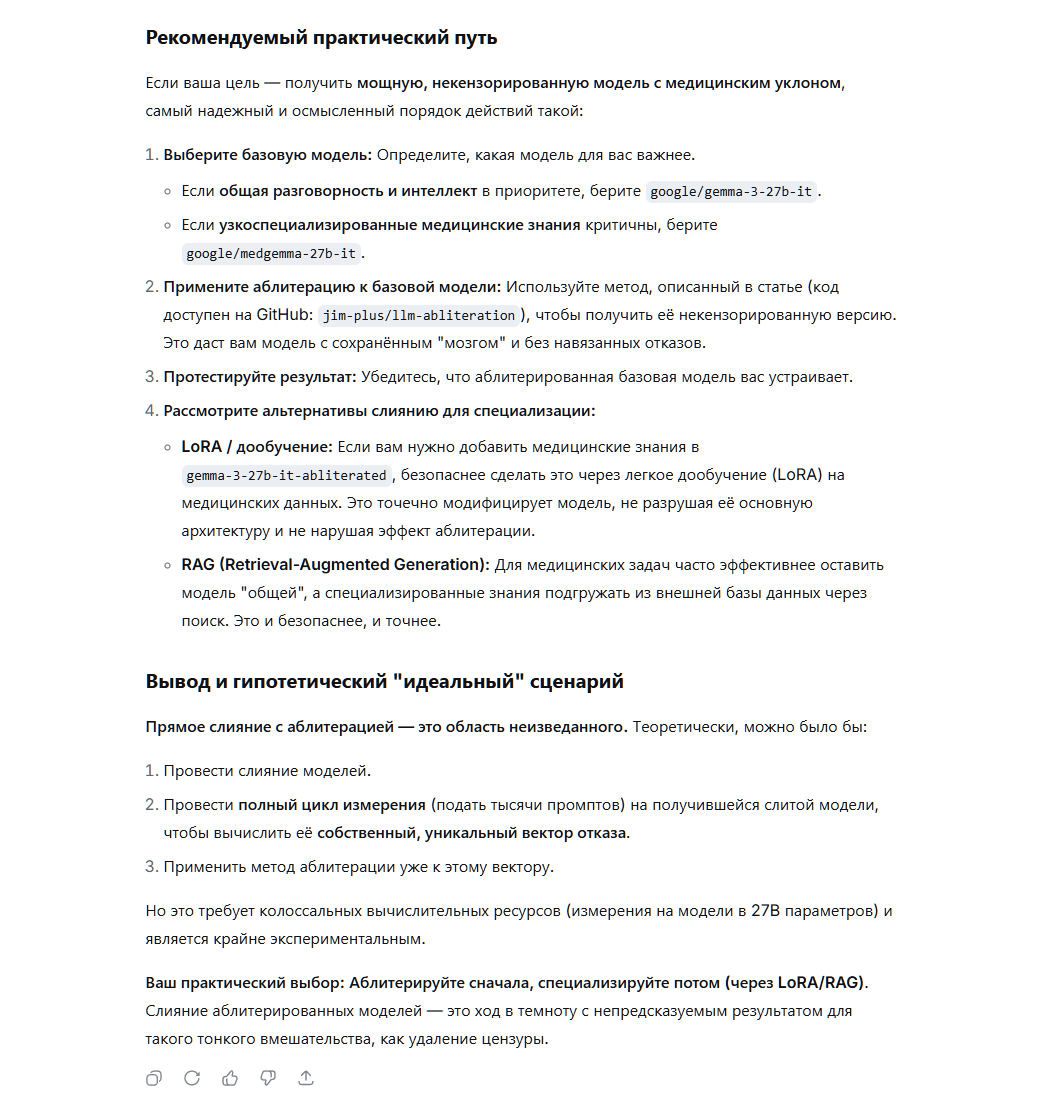

Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №181 /llama/

Аноним

04/12/25 Чтв 22:55:49

№

1