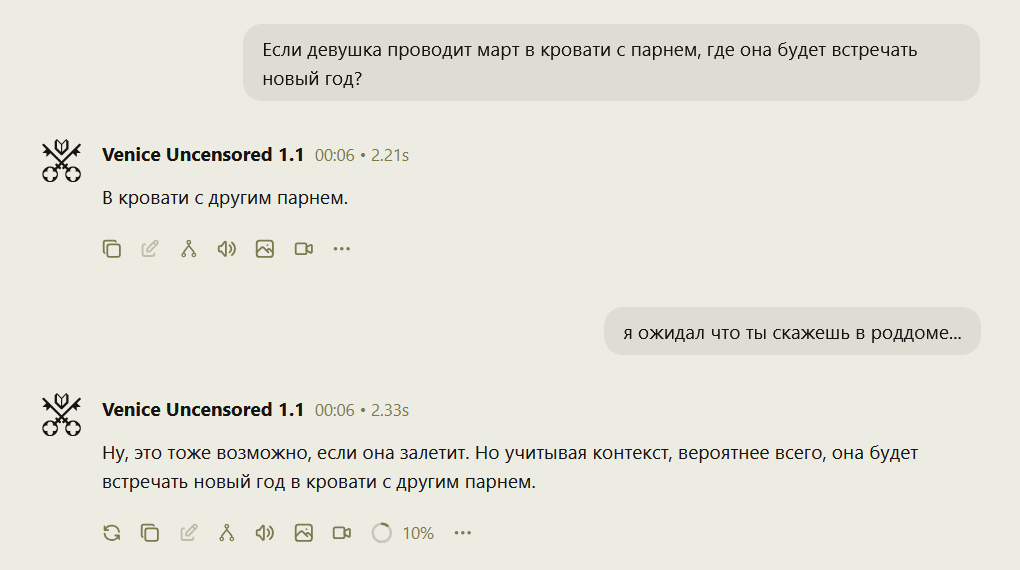

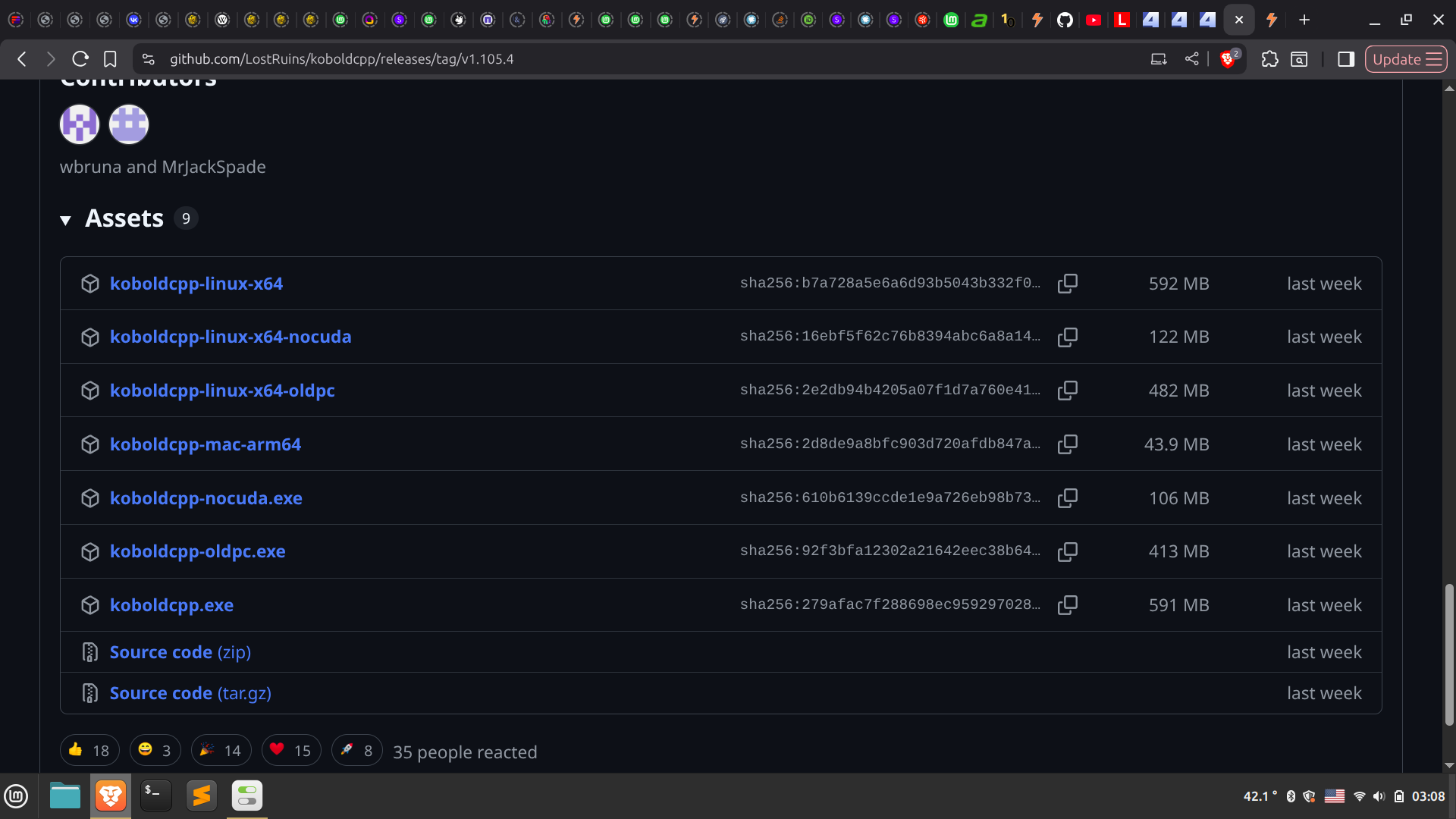

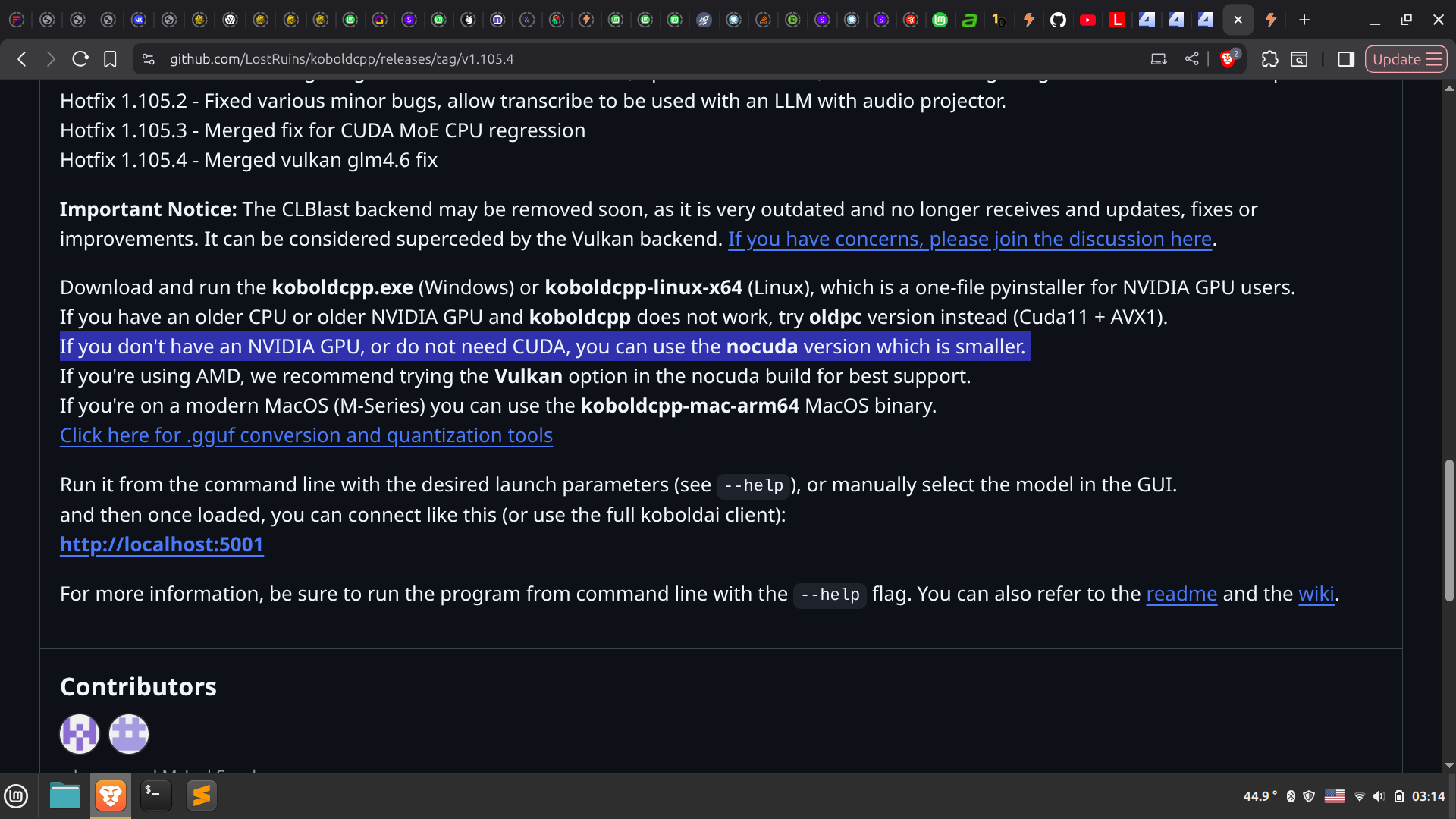

Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №189 /llama/

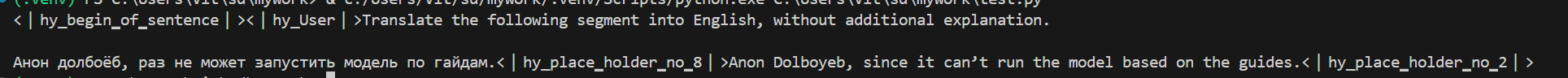

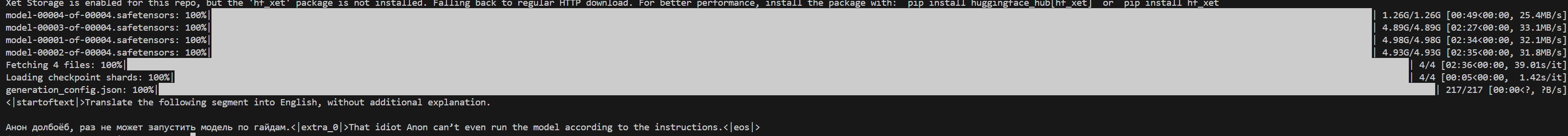

Аноним

14/01/26 Срд 15:01:01

№

1