Здравствуте. Я не программист, но у меня 2 вопрос к айтишникам о очень наболевшкем: 1.) существует

Аноним

26/01/26 Пнд 19:30:04

№

1

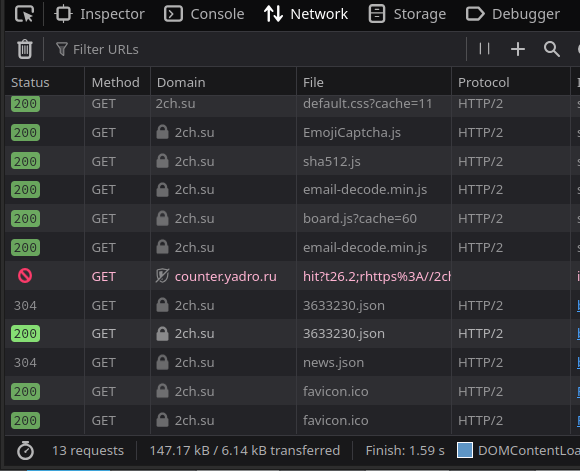

Я спросил у ChatGPT почему его первая страница с десятком слов и одним полем ввода грузится 20 минут

Аноним

26/01/26 Пнд 20:26:13

№

4