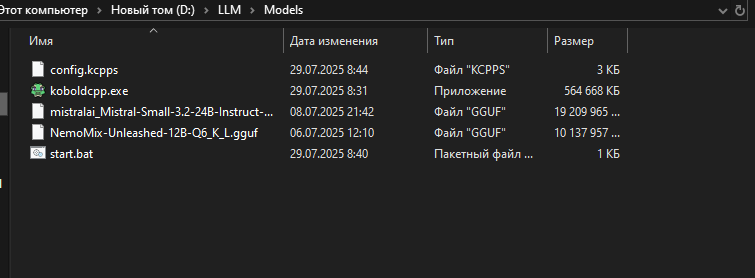

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №151 /llama/

Аноним

29/07/25 Втр 20:00:26

№

1