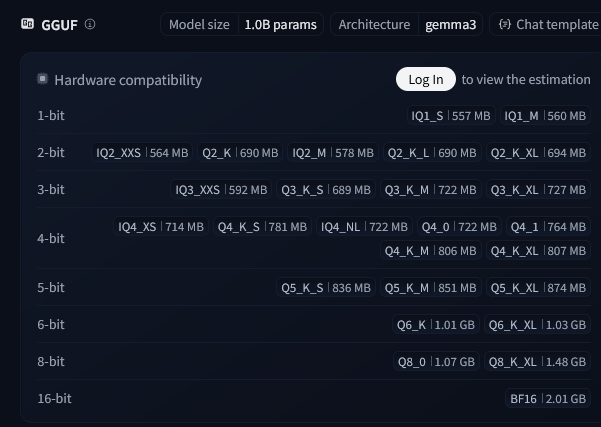

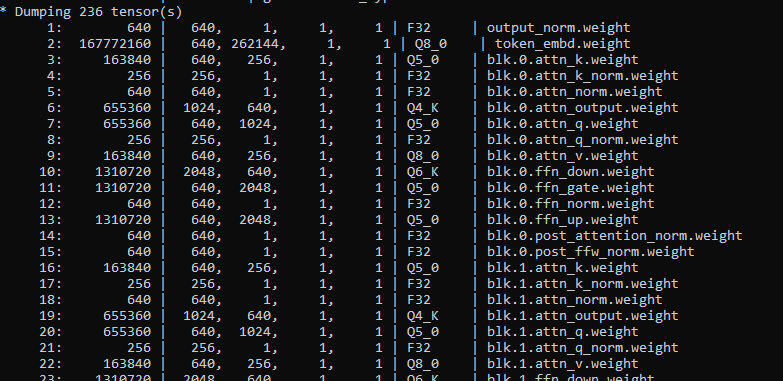

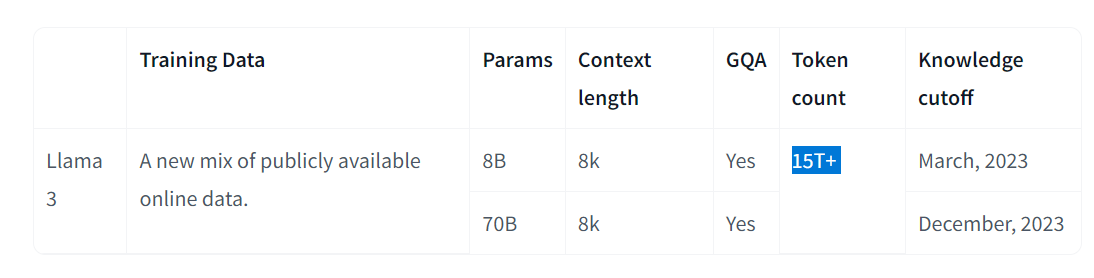

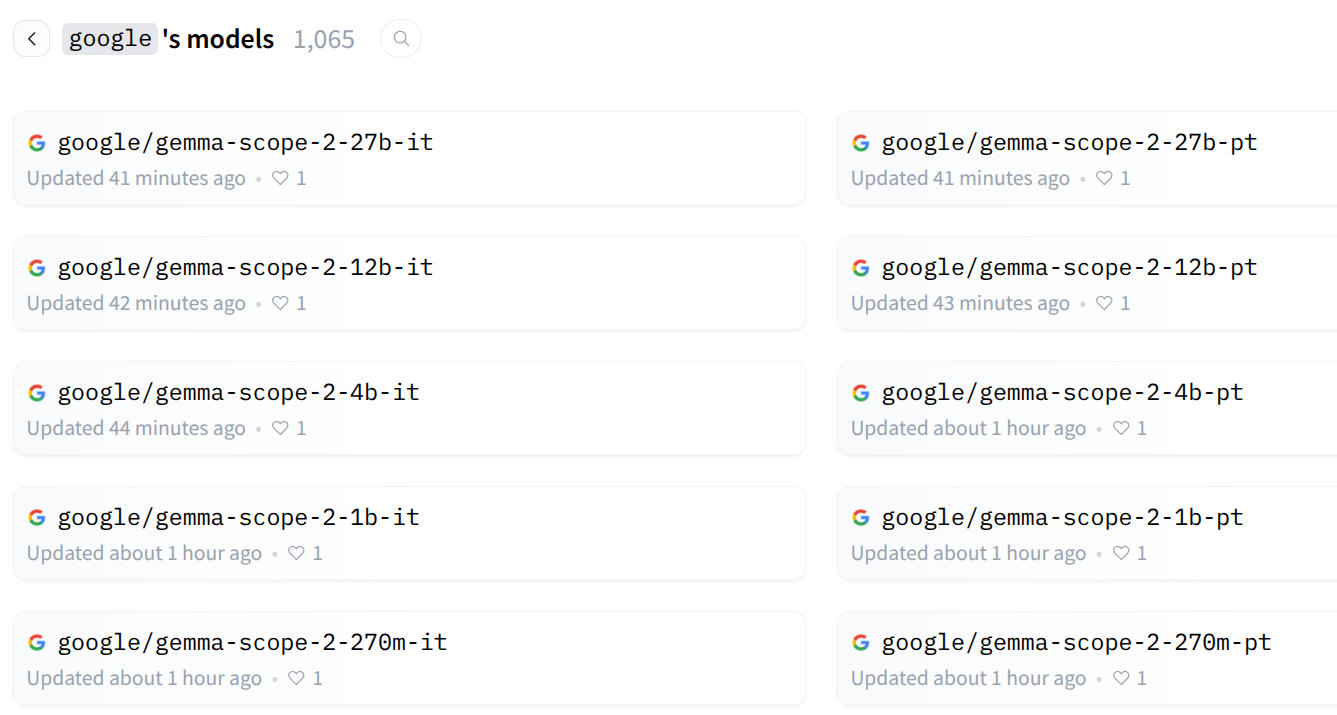

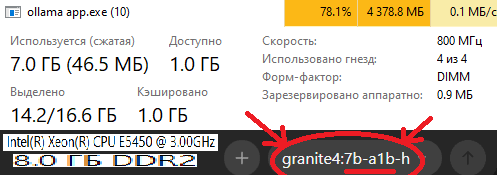

Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №183 /llama/

Аноним

16/12/25 Втр 01:15:50

№

1