Локальные языковые модели (LLM): LLaMA, Gemma, Qwen и прочие №174 /llama/

Аноним

27/10/25 Пнд 02:43:40

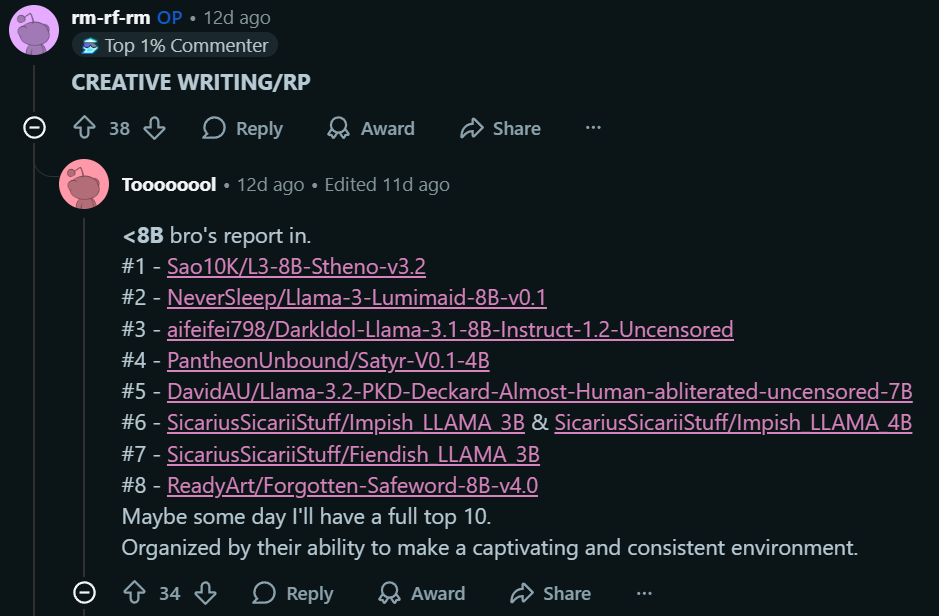

№

1